OmniTalker

4971

0

0

0

OmniTalker是阿里通义实验室开发的一款基于深度学习和多模态融合技术的新型数字人视频生成大模型。它能够通过上传一段参考视频,实现对视频中人物的表情、声音和说话风格的精准模仿,从而生成高度逼真的数字人视频。

工具标签:

直达网站

工具介绍

OmniTalker是什么?

OmniTalker是阿里通义实验室开发的一款基于深度学习和多模态融合技术的新型数字人视频生成大模型。它能够通过上传一段参考视频,实现对视频中人物的表情、声音和说话风格的精准模仿,从而生成高度逼真的数字人视频。

主要亮点

- 精准模仿能力:OmniTalker能够捕捉到参考视频中人物的细微表情和声音特点,生成与之高度相似的音视频内容,让人难以分辨真假。

- 降低成本:相较于传统的数字人制作流程,OmniTalker显著降低了制作成本,使得更多用户能够轻松拥有高质量的数字人服务。

- 增强真实感与互动体验:生成的音视频内容真实感极强,且由于能够精准模仿人物的声音和说话风格,为用户提供了更加自然、流畅的互动体验。

模型优势

- 多模态融合:OmniTalker实现了音频、视频和文本的多模态融合,使得生成的数字人更加生动、立体。

- 高效处理:模型采用先进的算法和架构,能够高效处理大量数据,快速生成高质量的音视频内容。

- 零样本学习:OmniTalker具备零样本学习能力,只需一段参考视频即可生成新的数字人视频,无需额外训练数据。

需求人群

- 内容创作者:如视频博主、主播等,可以利用OmniTalker快速生成高质量的数字人视频内容。

- 企业用户:企业可以利用OmniTalker制作虚拟客服、虚拟代言人等数字人形象,提升品牌形象和用户体验。

- 教育机构:教育机构可以利用OmniTalker制作虚拟教师、虚拟助教等数字人形象,为学生提供更加生动、有趣的学习体验。

适用场景

- 虚拟主播:利用OmniTalker生成虚拟主播形象,进行直播、录播等节目制作。

- 虚拟客服:企业可以利用OmniTalker制作虚拟客服形象,为用户提供24小时不间断的在线服务。

- 游戏与娱乐:在游戏和娱乐领域,OmniTalker可以生成虚拟角色形象,为玩家提供更加沉浸式的游戏体验。

使用便捷性

OmniTalker的使用非常简便。用户只需在平台上上传一段参考视频,选择相应的模板和参数设置,即可快速生成与之同步的音频和视频内容。目前,该项目已在魔搭社区和HuggingFace等平台开放体验,并提供了详细的教程和示例视频供用户参考。

OmniTalker如何使用

- 注册与登录:用户需要访问OmniTalker的官方网站或相关平台(如魔搭社区、HuggingFace等)进行注册和登录。

- 上传参考视频:在平台上上传一段清晰的参考视频,确保视频中的人物表情、声音和说话风格清晰可辨。

- 选择模板与参数:根据需求选择合适的模板和参数设置,如视频分辨率、帧率、音频质量等。

- 生成与导出:点击生成按钮,等待模型处理完成后即可导出生成的音视频内容。

技术背景与突破

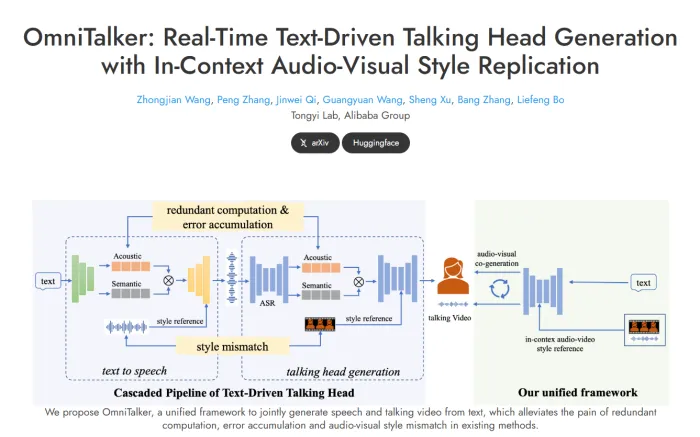

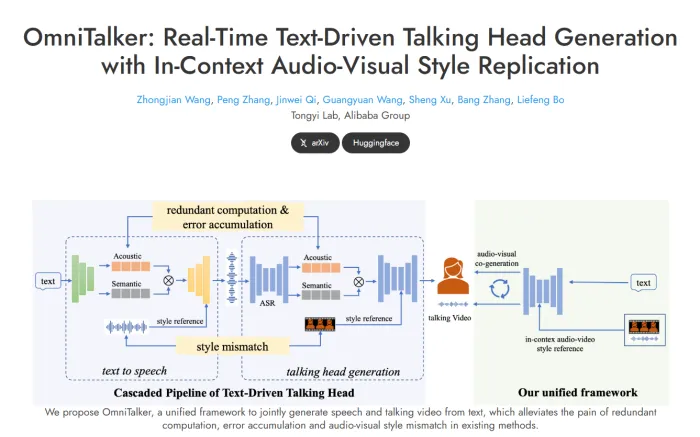

近年来,随着语言大模型和生成式AI的迅猛发展,虚拟主播和虚拟助手的应用越来越广泛。然而,传统的文本驱动数字人生成研究相对较少,且存在音画不同步、说话风格不一致等问题。OmniTalker通过引入双分支DiT架构和多模态特征融合技术,成功克服了这些技术瓶颈,实现了从文本和参考视频中同时生成同步的语音和视频。

模型结构与创新

OmniTalker的模型结构由三大核心部分构成:

- 特征提取模块:负责提取音频特征和视觉特征,并确保两者在时间上的完美同步。

- 多模态特征融合模块:将音频特征和视觉特征进行融合,提升音视频内容的整合效果。

- 解码器模块:经过预训练的解码器能够高效将合成的音视频特征转换为原始格式,保证输出的高质量。

此外,OmniTalker还采用了先进的Flow Matching训练技巧和优化算法,进一步提升了模型的性能和生成效果。

实验数据与表现

通过实验数据的对比和分析,OmniTalker在音频生成和视觉效果方面都表现出色。它显示出更低的错误率、更高的声音相似度和更逼真的视觉效果。特别是在零样本条件下,OmniTalker依然能够保持出色的生成效果,进一步证明了其强大的泛化能力和实用性。

未来发展

总的来说,阿里通义实验室推出的这款OmniTalker模型无疑是数字人生成领域的一大创新。它不仅降低了制作成本、提升了生成内容的真实感和互动体验,还为用户提供了更加简便、高效的使用方式。随着技术的不断进步和应用场景的不断拓展,相信OmniTalker将会在更多领域得到广泛应用,并为用户带来更加丰富的数字人体验。未来,我们期待OmniTalker能够继续引领数字人生成领域的发展潮流,为人工智能技术的进步贡献更多的力量。

评论

全部评论

暂无评论

热门推荐

相关推荐

天工AI大模型

昆仑万维天工AI大模型是昆仑万维集团自主研发的一系列大型语言模型(LLMs),旨在通过先进的自然语言处理和深度学习技术,为用户提供高效、智能的服务和体验。该系列模型不仅具备强大的语言理解和生成能力,还广泛应用于教育、企业客服、新闻媒体、创意产业、医疗、法律咨询、金融服务等多个行业。

零一万物

零一万物是李开复成立的一家专注于AI 2.0大模型技术研发与应用的创新企业。在AI 2.0时代,大模型成为核心技术,它能够处理海量数据,具备强大的通用性和创造性,可跨领域、跨媒体、跨语言地执行各种任务。零一万物以大模型为基础,致力于打造一个开放、共享、协作的大模型平台。

CivitAI - AI模型训练社区

CivitAI是一个专注于人工智能模型训练的平台,旨在为开发者、数据科学家和企业提供一个高效、可扩展的环境,以训练和部署机器学习模型

子曰

2023年7月26日,网易有道正式发布国内首个教育领域垂直大模型——“子曰”。其研发旨在运用人工智能技术,解决教育场景实际问题,为学习者提供更高效、个性化的学习体验。自发布以来,“子曰”不断升级迭代,在教育大模型垂直应用领域取得众多突破。2023年11月,顺利通过双新评估,成为首批通

日日新SenseNova

日日新SenseNova大模型是商汤科技推出的一款综合性人工智能大模型。它基于商汤科技深厚的学术积累和技术研发实力,集成了自然语言处理、内容生成、自动化数据标注、自定义模型训练等多种能力。

讯飞星火

讯飞星火大模型是一款科大讯飞倾力打造的AI对话大模型产品,凭借其卓越的跨领域知识与语言理解能力,正逐步成为用户的得力助手。通过自然对话的方式,讯飞星火能够精准理解与执行用户指令,涵盖写作、绘画、搜索、问答、翻译、阅读等多元化功能。最新推出的讯飞星火4.0Turbo,在七大核心能力上更是全面超越GPT

Lipsync-2

Lipsync-2是由Sync Labs公司推出的全球首个零-shot嘴型同步模型。在Ai视频技术发展的当下,嘴型同步技术对于提升视频的真实感和表现力至关重要。传统的嘴型同步技术往往需要大量的训练数据和针对特定演讲者的预训练,过程繁琐且效率低下而Lipsync-2的出现,打破了这一传统模式的束。

Llama3.1 Nemotron Ultra 253B

Llama3.1 Nemotron Ultra 253B是英伟达(NVIDIA)于2025年4月8日发布的最新大型语言模型(LLM)。这款模型基于Meta的Llama-3.1-405B-Instruct开发,通过创新的神经架构搜索(NAS)技术进行了深度优化,旨在提供高效、高性能的AI解决方案。

0

0