工具介绍

面壁露卡

千亿多模态大模型

智能对话助手:基于面壁智能的新一代大语言模型,能与你互动对话,帮你了解世界知识、激发创作灵感、理解图片内容、处理数理逻辑、编写程序代码,帮助你更好地获取信息、做出规划、解决问题

「面壁露卡 Luca」是面壁智能基于自研千亿参数基座模型 CPM 打造的多模态智能对话助手。

Luca 具备中英文语言对话、代码、知识、逻辑及图片理解能力。

面壁智能将进一步将 AI Agent 技术与 Luca 结合,发挥大模型应用潜能。

面壁智能与清华大学、OpenBMB 开源社区合作,推动大模型技术在各行各业的落地。

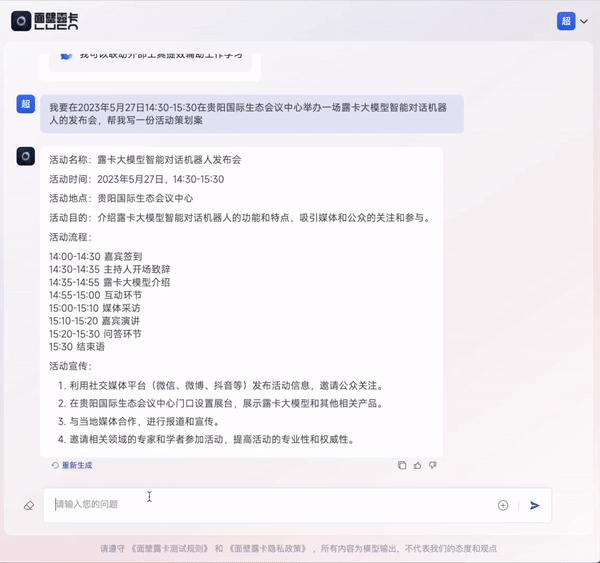

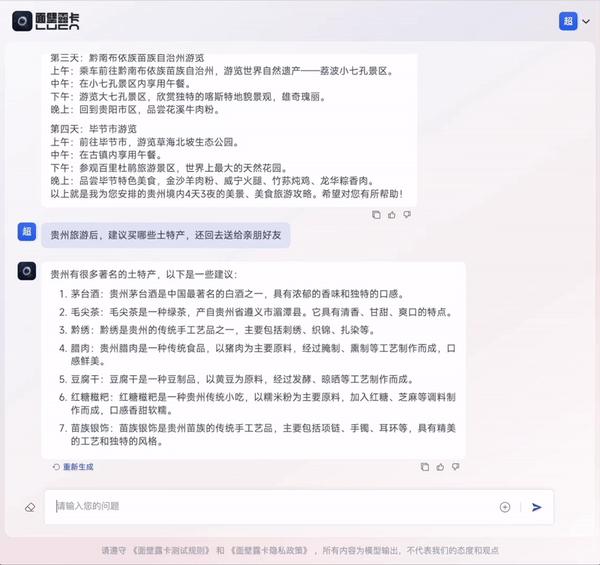

01 内容自动生成:贴心办公小助手

目前“露卡”(Luca)支持多轮对话与深度语义理解,可以根据输⼊文本语境和创作要求 ⾃动⽣成原创文案,并进一步进行改写或翻译,可以具体运用到诸多办公生活场景。发布会现场,“露卡”(Luca)自己给自己写了发布会的策划案,还写了邀请媒体朋友参加发布会的邮件并翻译成英文版本。

在发布会的示例中,“露卡”(Luca)还支持结构化内容生成,可以 一键生成表格和代码。

02 多模态输入理解:升级传统任务处理

“露卡”(Luca)具备多模态输入理解的能力,能够识别和解读图片,升级了传统自然语言理解任务处理(情感分析、信息抽取等)的能力。比如,发布会中上传了一张男孩的图片,“露卡”(Luca)就判断分析出了男孩的年纪和情绪。

03 联网信息检索摘要:最强学习效率工具

在支持多轮对话、多模态深度语义理解的基础上,“露卡”(Luca)最炫酷的功能就是能够联网进行信息搜索和摘要。示例中,输入“我想速读gpt4技术报告这篇论文 ”的需求,露卡(Luca)就反馈生成了一个图文并茂、结构清晰的论文概要,还能根据论文内容进一步回答用户提出的相关问题。

“露卡”拥有强大的 工具使用 能力,大模型与外部工具的有机结合弥补了当前主流大模型的能力短板。可以想象,当模型学会了像人类一样“上网”,并具备分析复杂问题的逻辑推理能力,那么我们离AGI(通用人工智能)就更近了一步。

“露卡”(Luca)将 首先定向邀请部分用户先行试用并提供宝贵反馈。基于反馈,我们仍会继续迭代打磨,推动模型能力不断升级,待产品进一步成熟,再对公众开放测试。

评论

全部评论

暂无评论

热门推荐

相关推荐

书生大模型

书生大模型由上海人工智能实验室倾力打造,模型凭借其庞大的参数规模与卓越的功能特性,在语言理解、数学解题、图文创作等多个维度上展现出了非凡的实力。书生大模型家族涵盖了多个杰出成员,诸如书生·多模态、书生·浦语以及书生·天际等,它们在性能卓越的同时,也在各自的专业领域内发挥着不可替代的作用。

Sec-Gemini v1

Sec-Gemini v1是谷歌基于其Gemini模型构建的一款全新AI安全模型。它集成了Gemini的先进推理能力,并结合了近乎实时的网络安全知识和工具,旨在帮助网络安全专业人员更有效地应对网络威胁,提升威胁情报分析、漏洞理解和事件响应的效率。

Quasar Alpha

Quasar Alpha是一款近期神秘亮相的全新AI模型,由一家未具名的模型实验室推出,被称为其首款“隐秘”模型,是即将发布的长上下文基础模型的预发布版本。它凭借超长的上下文处理能力、优化的编码能力,以及免费开放策略,迅速成为业界热议焦点,为AI技术发展增添了新期待。

CogView4

CogView4是智谱AI推出的开源中文文生图模型。CogView4 的参数规模精准布局至 6 亿,这一参数规模,为模型构建了一个庞大且高效的 “智慧中枢”,赋予其极为强大的运算和学习能力。还全面支持中文输入和中文文本到图像的生成,被称其为“首个能在画面中生成汉字的开源模型”

Waver

Waver是由Foundation Vision团队开源的通用视频生成大模型,它把文本-视频(T2V)、图像-视频(I2V)、多机位叙事、长时长高分辨率生成等能力整合到同一套权重里,无需额外微调即可直接输出5 s / 10 s、720 p / 1080 p的成品视频。

Video-XL-2

Video-XL-2是智源研究院联合上海交通大学等机构于2025年6月发布的超长视频理解模型,其核心突破在于单张显卡即可处理万帧级视频输入(约1小时时长的30FPS视频),同时保持轻量化设计(参数规模远低于720亿参数的闭源模型)。

开搜AI搜索

开搜AI搜索,这款国产的AI搜索引擎平台,致力于为用户提供如同Google搜索般高效、便捷的搜索体验。它利用先进的AI技术,精准把握用户的搜索意图,快速呈现最相关、最可靠的信息,让您无需像使用soso搜索时那样翻阅多个网页。

豆包AI官网

豆包AI(doubao)是字节跳动开发的AI智能助手,能通过文字与用户互动,提供聊天、知识解答、创意内容生成等服务,像回消息、解数学题、写文案都不在话下。它基于先进技术,持续优化以理解用户需求,为大家带来便捷的智能交互体验,是日常生活和工作中可信赖的AI助手。

0

0