ThinkSound

4007

0

0

0

ThinkSound是阿里巴巴通义实验室推出的全球首款音频生成模型。它采用先进的链式推理(Chain-of-Thought,CoT)技术,能够深入分析视频画面的场景、动作与情感,进而生成与之高度匹配的音效。无论是自然风声、城市喧嚣,还是角色对话与物体碰撞音,ThinkSound都能实现音画高保真同步

工具标签:

直达网站

工具介绍

ThinkSound是什么?

ThinkSound是阿里巴巴通义实验室推出的全球首款音频生成模型。它采用先进的链式推理(Chain-of-Thought,CoT)技术,能够深入分析视频画面的场景、动作与情感,进而生成与之高度匹配的音效。无论是自然风声、城市喧嚣,还是角色对话与物体碰撞音,ThinkSound都能实现音画高保真同步,效果逼真自然,堪称“专业AI音效师” 。

功能特点

1.多模态输入

支持视频、文本、音频或其组合等多种输入方式。

- 用户既可以通过详细的文字描述,让模型生成符合特定场景的音效,比如“在一个古老的城堡中,阴森的风声呼啸而过,偶尔传来水滴落下的声音”;

- 也可以直接上传一段视频片段,模型便能根据视频内容生成适配的音效;

- 甚至还能通过音频输入,让模型在已有音频基础上进行拓展或修改 。例如,上传一段节奏舒缓的音乐,要求模型添加一些鸟鸣声和流水声,营造出更加自然的氛围。

2.交互式编辑

提供交互式编辑功能,支持通过点击或语言指令对特定音效进行精细调整。创作者在生成音效后,如果觉得某个部分不太满意,比如觉得一段打斗场景中的武器碰撞声不够清脆,就可以通过点击视频中对应的画面位置,然后输入指令“让武器碰撞声更清脆响亮”,模型便会按照要求对音效进行优化 。

3.广泛的格式与分辨率支持

其算法确保音频与视频帧精准对齐,支持MP4、MOV、AVI和MKV等多种视频格式,并且兼容从标清到4K分辨率,无论创作者使用何种设备、何种画质要求进行创作,ThinkSound都能很好地满足 。

核心优势

1.多模态融合

融合了计算机视觉、自然语言处理与音频生成技术。先进的计算机视觉算法逐帧分析视频内容,理解物体交互、环境背景及人物行为,从而生成高度契合的音效与音景。

- 在自然场景中,可生成潺潺流水或鸟鸣声;

- 在都市场景中,能精确还原车辆鸣笛与人群喧闹 。

例如,当分析一段森林中的视频时,模型能识别出树木、溪流、飞鸟等元素,进而生成与之对应的风声、流水声、鸟鸣声,并且这些声音的音量、节奏、空间位置等都与视频中的画面完美匹配 。

2.高精度同步

在音画同步方面表现尤为出色。官方数据显示,ThinkSound在视频-音频生成基准测试中位居行业前列,其生成的音频与视频画面的同步精度极高,有效避免了传统音效生成中常见的音画不同步问题,为观众带来更加沉浸式的体验 。

技术原理

ThinkSound首次将思维链(CoT)技术应用于音频生成领域。通过引入结构化推理机制,模型先理解视频整体画面与场景语义,再聚焦具体声源对象,最后响应用户编辑指令,逐步生成高保真且同步的音频。

它由多模态大语言模型和统一音频生成模型组成。多模态大语言模型负责“思考”推理链,基于流匹配的统一音频生成模型负责“输出”声音 。面对一段表现厨房烹饪的视频,多模态大语言模型首先会分析视频中出现的各种元素,如炉灶上的火焰、锅里翻炒的食物、旁边水龙头流出的水等,然后根据这些元素的运动状态、相互关系等信息,推理出应该产生的声音,比如火焰的呼呼声、食物翻炒的滋滋声、水流的哗哗声等。接着,统一音频生成模型根据这些推理结果,生成对应的高保真音频 。

数据集支持

通义语音团队构建了首个支持链式推理的多模态音频数据集AudioCoT。它融合了来自VGGSound、AudioSet、AudioCaps、Freesound等多个来源的2531.8小时高质量样本,覆盖从动物鸣叫、机械运转到环境音效等多种真实场景,为模型提供了丰富而多样化的训练基础。

为确保每条数据都能真正支撑AI的结构化推理能力,研究团队设计了一套精细化的数据筛选流程,包括多阶段自动化质量过滤和不少于5%的人工抽样校验,层层把关以保障数据集的整体质量。在此基础上,AudioCoT还特别设计了面向交互式编辑的对象级和指令级样本,以满足ThinkSound在后续阶段对细化与编辑功能的需求 。

性能表现

在开源的VGGSound测试集上,ThinkSound的多项核心指标相比现有主流方法如MMAudio、V2A - Mappe、V - AURA等,均实现了15%以上的提升。在代表模型对声音事件类别和特征判别精准度的KLPaSST和KLPaNNs两项指标上,取得了同类模型中的最佳成绩。在电影复杂场景数据集MovieGenAudioBench上,ThinkSound也以20%的优势超越Meta的MovieGenAudio模型 。这充分证明了ThinkSound在音频生成质量、对声音事件的理解和处理能力等方面的卓越性能 。

应用场景

1.影视后期制作

能够快速为无声视频生成环境音效、角色对话或背景音乐,显著提升后期制作效率。在一部古装剧中,制作团队可以利用ThinkSound为一段宫殿内的场景快速添加环境音效,如微风拂过窗帘的声音、远处传来的钟声等,增强场景的真实感和氛围感 。对于一些没有现场收音条件或者需要重新配音的场景,ThinkSound也能根据画面内容生成合适的角色对话音效 。

2.游戏音效设计

游戏开发者可利用其生成动态音效,为虚拟场景增添沉浸感。在一款冒险游戏中,当玩家进入一个神秘的洞穴时,ThinkSound可以根据洞穴的环境特征,如潮湿的墙壁、滴答的水滴、狭窄的通道等,生成相应的音效,如水滴声、风声在洞穴内的回响等,让玩家更加身临其境 。而且,随着玩家在游戏中的行动和场景的变化,音效也能实时动态调整 。

3.互动媒体及教育内容创作

其语音合成技术支持多语言对话生成,结合精准的唇部同步与情感表达,为虚拟角色赋予更真实的生命力。在一个在线教育课程中,虚拟老师的讲解可以通过ThinkSound生成自然流畅的语音,并且语音的情感、语调等都能根据讲解内容进行调整 。在互动媒体中的虚拟角色,如智能客服、虚拟导游等,也能借助ThinkSound的技术,以更加生动、自然的语音与用户进行交互 。

开源情况

ThinkSound的模型权重与推理脚本已在GitHub、Hugging Face、魔搭社区等平台全面开源,开发者可以免费获取。这一举措大幅降低了AI音效生成的技术门槛,使中小型创作者、独立开发者及学术研究人员能够轻松接入专业级音效生成工具,有助于推动音频生成技术的发展和创新,促进更多基于该模型的二次开发和应用场景的拓展 。

如何使用

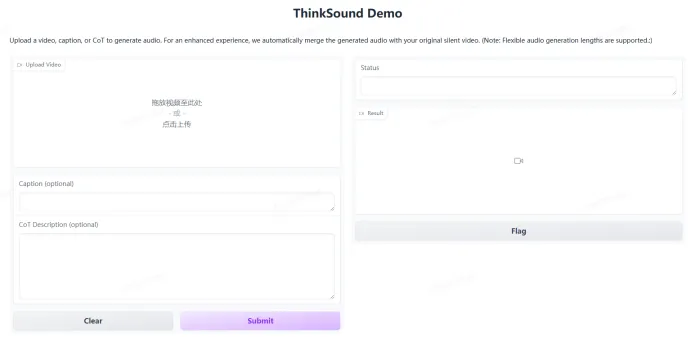

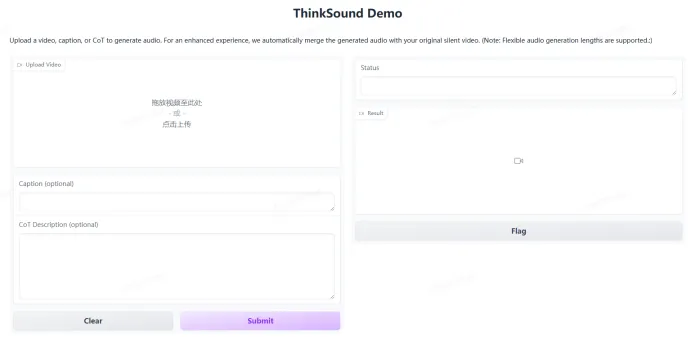

在线体验

用户可以通过访问https://www.modelscope.cn/studios/iic/ThinkSound,在网页上直接上传视频或输入文本描述,体验ThinkSound的音频生成功能。按照页面提示操作,即可快速获得生成的音效 。

开发者接入

对于开发者而言,如果想要在自己的项目中集成ThinkSound,可以从上述开源平台获取模型权重与推理脚本。根据官方提供的文档和教程,将模型接入到自己的开发环境中,然后通过编写代码来调用模型的功能,实现根据视频、文本等生成音频的操作 。例如,在Python环境中,利用相应的库和接口,按照文档说明的参数设置和调用方式,就可以实现对ThinkSound模型的调用 。

想了解AITOP100平台其它版块的内容,请点击下方超链接查看

AI创作大赛 | AI活动 | AI工具集 | AI资讯专区

AITOP100平台官方交流社群二维码:

评论

全部评论

暂无评论

热门推荐

相关推荐

ChatOne

ChatOne是一款由深圳市奇思妙物科技有限公司开发的AI大模型聚合平台,整合国内外主流AI模型(如GPT-4、文心一言等),提供多场景智能交互服务。其核心定位为“一站式AI生产力工具”,通过自然语言交互实现内容创作、知识管理、客服自动化等功能,旨在降低AI技术使用门槛,提升个人与企业效率。

智谱清言

智谱清言是由北京智谱华章科技有限公司推出的一款生成式AI助手,也可被称为ChatGLM。它集文本生成、图片生成、音视频生成等多种功能于一体的智能创作系统,基于深度学习技术,可以实现文章自动生成、智能改写、关键词提取等功能。

Kimi-VL

Kimi-VL与Kimi-VL-Thinking是由国内知名人工智能公司Moonshot AI(月之暗面)于近期开源发布的两款视觉语言模型。这两款模型以其轻量级的架构和卓越的多模态理解与推理能力,迅速在行业内引起了广泛关注。它们不仅在多项基准测试中超越了包括GPT-4o在内的众多大型模型。

火山方舟

火山方舟是火山引擎旗下的大模型服务平台,定位为面向企业提供全面的模型即服务(MaaS,Model-as-a- Service)解决方案。它汇聚百川智能、出门问问、复旦大学MOSS、IDEA研究院、澜舟科技、MiniMax、智谱AI等多家 AI 科技公司及科研院所的大模型,打破模型资源分散的局面。

liblibAI

Liblib社区,也被称为哩布哩布AI,是一个专注于AI绘画的原创模型分享社区。它由北京奇点星宇科技有限公司提供,致力于激发原创AI模型和素材的创作。在这个平台上,用户可以找到最新、最热门的模型素材,并且可以免费下载超过10万个原创模型。

Magma AI

Magma是一款由微软精心打造的多模态AI模型,它旨在处理和整合图像、文本和视频等多种数据类型。与传统的AI系统不同,Magma不仅仅专注于视觉-语言理解或机器人操作等单一领域,而是将这两种能力结合成一个统一的模型,使得AI代理能够在数字和物理环境中执行更为复杂的任务。

日日新SenseNova

日日新SenseNova大模型是商汤科技推出的一款综合性人工智能大模型。它基于商汤科技深厚的学术积累和技术研发实力,集成了自然语言处理、内容生成、自动化数据标注、自定义模型训练等多种能力。

Hugging Face

Hugging Face成立于2016年,作为全球大模型领域举足轻重的开放平台,最初以开发聊天机器人起步,怀揣着让人工智能技术惠及大众的愿景,逐渐转型为专注于开源人工智能,尤其是自然语言处理(NLP)技术,发展至今,它已构建起涵盖模型、工具、数据集以及活跃社区的庞大生态体系。

0

0