工具介绍

EasyControl:为DiT模型插上“ControlNet”的翅膀

在人工智能绘画领域,扩散模型(Diffusion Model)正经历着从基于Unet架构向基于Transformer架构(DiT)的深刻转变。然而,DiT生态系统在插件支持、效率以及多条件控制等方面仍面临诸多挑战。为了应对这些挑战,由Xiaojiu-z领衔的团队推出了名为EasyControl的创新框架,旨在为DiT模型提供高效且灵活的条件控制能力,犹如为DiT模型装上了强大的“ControlNet”。

EasyControl是什么?

EasyControl 是一款先进的框架,专为优化Diffusion Transformer(扩散变换器)的控制而设计。它致力于克服DiT生态系统中面临的效率制约和模型适应性问题。该框架的核心优势在于其能够支持多样化的条件组合,显著增强了图像生成的灵活性和推理速度。基于最新的研究进展,EasyControl 成为了图像生成和风格转换等领域内的理想选择。

EasyControl的核心优势

EasyControl并非简单的模型叠加,而是一套经过精心设计的统一条件DiT框架。其核心优势在于通过引入一系列创新技术,实现了显著的性能提升。

- 轻量级条件注入LoRA模块:这一模块允许条件信号的独立注入,避免了对基础模型权重的修改,从而支持了灵活的条件注入和多条件泛化。

- 位置感知训练范式:通过标准化输入条件以固定分辨率,实现了任意宽高比和灵活分辨率的图像生成,同时优化了计算效率。

- 因果注意力机制与KV缓存技术:这一创新显著降低了图像合成的延迟,提高了框架的整体效率。

这些创新设计使得EasyControl在模型兼容性(即插即用,风格无损控制)、生成灵活性(支持多种分辨率、宽高比和多条件组合)以及推理效率方面都表现出色。

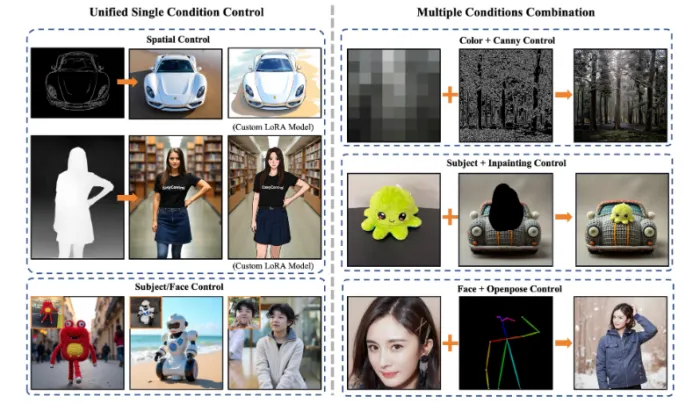

强大的多条件控制能力

EasyControl最引人注目的特性之一是其强大的多条件控制能力。它支持多种控制模型,包括但不限于:

- Canny边缘检测:用户可以指定生成物体的轮廓。

- 深度信息:用于生成具有深度感的图像。

- HED边缘草图:提供更精细的边缘控制。

- 图像修复(Inpainting):用于修复或编辑图像中的特定区域。

- 人体姿态(Pose):可以类比OpenPose,引导生成具有特定人物动作的图像。

- 语义分割(Seg):用于生成具有特定语义结构的图像。

这意味着用户可以通过输入不同的控制信号,精确地引导DiT模型生成符合特定结构、形状和布局的图像。这种细致的控制能力极大地拓展了DiT模型的应用场景。

令人惊艳的吉卜力画风转换

除了基础的结构控制,EasyControl还展现了强大的风格迁移能力,尤其是在吉卜力画风转换方面。研究团队利用仅100张真实亚洲人脸和GPT-4o生成的吉卜力风格对应图像进行训练,开发出专门的LoRA模型。该模型在将人像转化为经典吉卜力动画风格的同时,还能很好地保留原始面部特征。

用户只需上传人像照片,并配合相应的提示词,即可轻松生成具有浓郁手绘动漫风格的艺术作品。项目方还提供了Gradio演示,方便用户在线体验这一功能。这一特性无疑为动漫爱好者、设计师等提供了极大的创作便利。

EasyControl用户群体:

"本产品专为研究人员、开发者和图像生成领域的专业人士设计,尤其适用于那些追求高效图像生成及风格转换的用户。其卓越的灵活性和高效性能助力用户轻松实现创意构想和艺术表现。"

EasyControl应用场景:

- 通过 EasyControl,用户可快速生成高清图像,并轻松实现多样化的艺术风格转换。

- 利用 Ghibli 风格模型,轻松打造具有独特艺术气息的肖像画作。

- 在图像合成过程中,结合空间与主题条件,轻松构建复杂场景的图像。

EasyControl操作指南:

新建并激活 conda 环境。

安装必要的依赖库。

从 Hugging Face 平台下载所需的模型文件。

初始化模型,并加载控制参数。

根据预设条件,生成目标图像。

EasyControl未来发展

EasyControl项目团队目前已经发布了推理代码和预训练权重,为研究人员和开发者提供了初步的工具支持。根据其Todo List,未来还将推出空间预训练权重、主体预训练权重以及训练代码,这将进一步完善EasyControl的功能,并满足更多应用场景的需求。

EasyControl的出现无疑为基于Transformer的扩散模型注入了强大的控制能力,有效地弥补了DiT模型在条件控制方面的不足。其对多种控制模式的支持,以及令人印象深刻的吉卜力画风转换能力,都预示着其在AI内容生成领域拥有广阔的应用前景。凭借其高效、灵活和易用的特点,EasyControl有望成为DiT模型生态中一个重要的组成部分,推动人工智能绘画领域向更高层次发展。

评论

全部评论

暂无评论

热门推荐

相关推荐

百川大模型

百川大模型是百川智能基于先进的深度学习技术和大规模语料库训练得到的语言模型。它具备强大的自然语言处理能力和理解能力,能够生成自然、流畅、富有逻辑性的文本内容。包括闭源模型Baichuan4-Turbo、Baichuan4-Air和开源模型如Baichuan2-13B、Baichuan2-7B。

地球AI大脑

谷歌地球AI大脑是谷歌最新推出的一个地理智能分析平台,它整合了图像、地图、天气数据等多种信息,并利用AI模型进行深度学习。这个强大的系统可以自动理解并回答与地理位置相关的复杂问题,为人类提供前所未有的洞察能力。

Fabric 1.0

VEED Fabric 1.0是VEED.IO 推出的全球首款AI会说话视频模型,它实现了从静态图像到动态叙事的重大跨越,仅需一张图片结合语音输入,就能生成最长1分钟、具备逼真唇形同步和自然面部表情的会话视频。该模型专为“talking head”视频设计,生成速度极快,成本大幅降低,还集成多种生态

GAIA-2

GAIA-2是Wayve公司最新推出的一款专为辅助驾驶和自动驾驶设计的视频生成世界模型。它利用先进的生成式人工智能技术,能够模拟出各种复杂的驾驶场景,为自动驾驶系统的训练和验证提供丰富、多样的数据支持。

天工AI搜索

天工AI搜索 是由昆仑万维开发的一种AI搜索引擎,它融入了大语言模型的能力,提供智能、高效、快速的搜索体验。

VACE

阿里通义Wan团队推出的视频生成和编辑模型VACE,是一款集多功能于一体的创新工具,它支持按条件生成视频、精确控制物体运动轨迹、一键替换视频主体、风格迁移、画面扩展及静态画面动态化等,极大地提升了视频创作的效率和趣味性,为视频内容创作领域带来了全新的可能性。

无问芯穹

无问芯穹(Infinigence),一个专为大型模型应用开发者量身打造的企业级AI服务平台,正引领着我们步入AIGC(人工智能生成内容)的新纪元。它致力于在AI 2.0时代提供创新解决方案,搭建起大模型与多样化芯片之间的高效部署桥梁,为通用人工智能(AGI)时代的基础设施建设贡献力量。

DeepSeek-V3-0324

DeepSeek-V3-0324是DeepSeek在3月25日推出的一款拥有685亿参数的先进文本生成模型,它支持BF16和F32张量类型,能够高效地进行推理和文本生成。这款模型的定位非常明确,就是为自然语言处理领域的研究人员、开发者以及内容创作者提供一个强大的工具,帮助他们在文本生成领域取得突破。

0

0