AniSora

7783

0

0

0

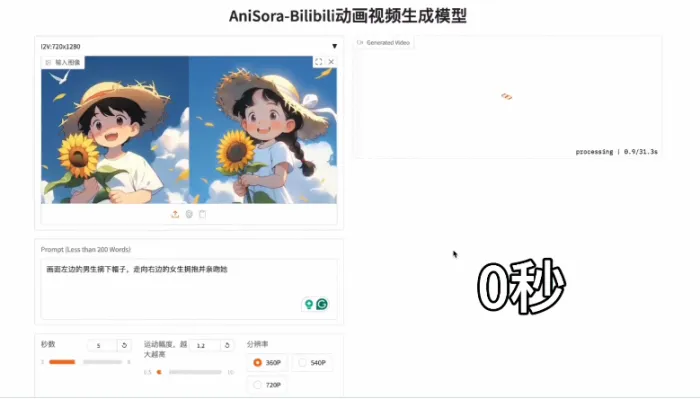

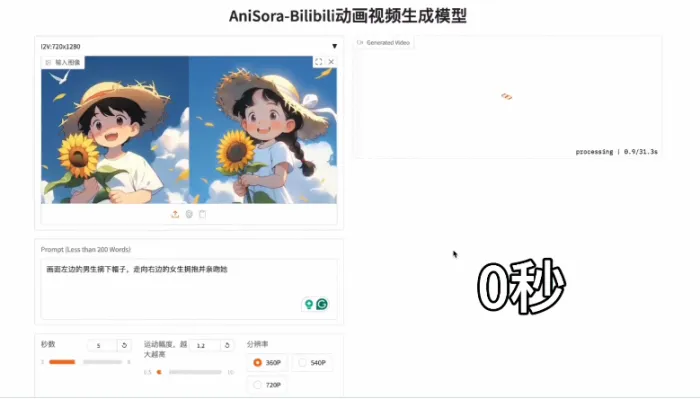

Bilibili(B站)的开源动漫视频生成模型AniSora是专为动漫视频生成设计的综合系统,该模型具备海量数据支持、时空掩码技术、专业评估体系三大核心优势,可一键生成多种动漫风格的视频内容,显著降低创作门槛并提升制作效率。

工具标签:

直达网站

工具介绍

一、AniSora是什么?

AniSora是B站团队基于IJCAI 2025接收的论文成果开发的开源动漫视频生成系统,其技术定位可概括为:

- 专为二次元内容优化:针对动漫独特的艺术风格(如日漫、国漫、美漫)、夸张动作(如超高速移动、非物理变形)及多样化场景(番剧、VTuber表演、鬼畜动画)设计,突破传统模型在动漫生成中的局限性。

- 全链路可控生成:通过时空掩码模块实现图像到视频、帧插值、局部区域引导等核心功能,支持从单张图片生成连贯动画,或对已有视频进行精准编辑。

- 开源生态构建:提供完整训练代码、预训练模型及评估基准,支持在RTX 4090等消费级硬件上部署,降低技术门槛,促进社区协作。

二、核心能力:

1. 千万级数据处理流水线

- 数据规模:整合超过1000万条高质量文本-视频配对数据,覆盖中、日、美三大动画流派,涵盖番剧、国创、漫画改编、VTuber内容等30余个场景。

- 数据预处理:通过视频时空特征提取、字幕与水印移除等技术,确保数据质量,避免生成伪影(如乱码字幕)。

2. 时空掩码可控生成模型

- 图生视频(Image-to-Video):上传单张图片即可生成连贯动态视频,支持自定义角色动作、镜头运动(如缩放、旋转)。

- 帧插值(Frame Interpolation):在关键帧间智能插入中间帧,实现平滑过渡,支持首尾帧引导、多帧插值等模式,减少手工绘制工作量。

- 局部图像引导(Localized Motion Control):通过遮罩技术精准控制特定区域(如角色面部、肢体)的运动,结合前景检测与目标跟踪,实现复杂动作编辑。

- 技术框架:基于Masked Diffusion Transformer,采用3D Causal VAE编码时空特征,结合3D-RoPE(三维相对位置编码)与全局注意力机制,提升动态一致性与细节保真度。

3. 强化学习优化与评估体系

- AnimeReward系统:构建高质量奖励数据集,通过人类偏好对齐(RLHF)优化生成内容的自然度与观感。

- 评估基准:发布包含948段动画视频的评测数据集,通过双盲人评实验与VBench测试,在人物一致性、运动流畅性等维度达到SOTA(行业领先水平)。

三、需求人群:

- 动画工作室与独立创作者:快速生成高质量动画片段,降低制作成本(如传统手绘需数周完成的分镜,AniSora可实时生成)。

- 虚拟主播(VTuber)运营团队:生成舞蹈、表演等动态视频,丰富直播内容,提升观众互动。

- 漫画IP孵化方:将静态漫画快速转化为动画,拓展IP价值(如《一人之下》等国漫IP可通过AniSora生成PV宣传片)。

- 教育机构与学习者:作为教学工具,帮助学生掌握动画制作技巧(如通过局部引导功能理解运动规律)。

- 营销与娱乐内容团队:生成动画广告、社交媒体短视频,提升传播效果(如品牌方可快速制作二次元风格产品宣传片)。

四、应用场景:

1. 动画制作

- 案例:某小型动画工作室使用AniSora生成番剧《灵笼》的战斗场景,通过图生视频功能将概念图转化为动态视频,结合帧插值优化动作流畅性,制作周期缩短60%。

- 优势:支持多风格生成(如2D手绘、3D建模),适配不同项目需求。

2. VTuber内容创作

- 案例:虚拟主播“琉绮Ruki”利用AniSora生成舞蹈表演视频,通过局部引导功能精准控制角色肢体动作,实现与观众实时互动。

- 优势:降低内容制作门槛,提升直播吸引力。

3. 漫画改编与IP孵化

- 案例:快看漫画使用AniSora将《偷偷藏不住》改编为动态漫画,通过帧插值技术优化角色对话场景,用户留存率提升35%。

- 优势:快速验证IP市场潜力,降低试错成本。

4. 教育与培训

- 案例:中国传媒大学动画学院将AniSora引入教学,学生通过局部引导功能实践“角色口型同步”技术,学习效率提升50%。

- 优势:提供低成本、高效率的实践工具。

5. 营销与娱乐

- 案例:某品牌通过AniSora生成二次元风格产品广告,结合强化学习优化视觉风格,用户点击率提升40%。

- 优势:满足年轻用户对个性化内容的需求。

五、如何使用AniSora?

1. 本地部署(以AniSora V1.0为例)

硬件要求:4张RTX 4090显卡(或等效算力设备)。

步骤:

- 创建虚拟环境:使用Miniconda安装Python 3.10,并激活环境。

- 克隆仓库:从GitHub下载项目代码(

git clone https://github.com/bilibili/Index-anisora.git)。 - 安装依赖:修改

requirements.txt中的pyav为av,并执行pip install -r requirements.txt。 - 下载模型:从HuggingFace或ModelScope下载预训练权重(如

CogVideoX_VAE_T5、5B模型权重),并放置于指定目录。 - 模型推理:运行

python demo.py --base configs/cogvideox/cogvideox_5b_720_169_2.yaml生成视频。

2. 开发接口与插件扩展

- API支持:提供RESTful API,开发者可通过HTTP请求调用模型生成视频。

- 插件生态:支持自定义插件开发(如连接企业微信、数据库查询),扩展应用场景。

六、行业影响:

1. 技术普惠:降低创作门槛

- 零代码开发:业务人员可通过自然语言描述快速生成视频,无需专业编程技能。

- 硬件适配:与昆仑芯合作推出“文心一体机”,推理延迟降至10毫秒,支持本地化部署,满足金融、政务等高安全需求场景。

2. 生态闭环:从开发到变现的全链路支持

- 流量分发:智能体可一键部署至B站搜索、文心一言App、小度音箱等10余个渠道,日均触达用户超5亿。

- 商业变现:提供订阅制、按需付费等模式,某教育机构通过付费问答功能实现月收入超20万元。

3. 全球化布局:推动中国AI标准输出

- 多语言支持:平台已支持中英文双语开发,并与IBM、蓝美视讯等国际企业合作,在东南亚、欧洲市场落地“存储+AI”解决方案。

- 开源协作:通过GitHub等平台吸引全球开发者贡献代码,加速技术迭代。

AniSora,开启AI动漫普惠新时代

AniSora的开源不仅是B站在AI领域的技术突破,更是对动漫创作生态的重构。从降低制作门槛的零代码工具,到覆盖全场景的智能体解决方案,AniSora正在让每个个体都能参与到AI创新中。

未来,随着多模态感知、MCP协议等技术的成熟,智能体将进一步跨越“可用”与“好用”的门槛,成为连接物理世界与数字世界的核心纽带。AniSora,正以开放、协同的姿态,携手全球开发者共同迈向AGI(通用人工智能)的星辰大海。

想了解AITOP100平台其它版块的内容,请点击下方超链接查看

AI创作大赛 | AI活动 | AI工具集 | AI资讯专区

AITOP100平台官方交流社群二维码:

评论

全部评论

暂无评论

热门推荐

相关推荐

Parakeet-TDT-0.6B-V2

Parakeet-TDT-0.6B-V2是英伟达在语音识别技术领域的又一力作,它基于先进的FastConformer架构,并融合了创新的TDT解码器,是一款专注于英文自动语音识别的强大模型。作为Parakeet模型的升级版本,它不仅继承了前代模型的优秀基因,还在性能和功能上实现了重大突破。

地球AI大脑

谷歌地球AI大脑是谷歌最新推出的一个地理智能分析平台,它整合了图像、地图、天气数据等多种信息,并利用AI模型进行深度学习。这个强大的系统可以自动理解并回答与地理位置相关的复杂问题,为人类提供前所未有的洞察能力。

魔搭社区

ModelScope魔搭社区是一个由阿里巴巴达摩院联合CCF开源发展委员会共同推出的中文AI模型开源社区。它致力于汇集业界领先的模型和丰富的数据集,为科研机构和科技公司提供一个分享和建设的平台。ModelScope的推出旨在降低AI应用门槛,推动技术创新和原创性模型研究的发展。

VACE

阿里通义Wan团队推出的视频生成和编辑模型VACE,是一款集多功能于一体的创新工具,它支持按条件生成视频、精确控制物体运动轨迹、一键替换视频主体、风格迁移、画面扩展及静态画面动态化等,极大地提升了视频创作的效率和趣味性,为视频内容创作领域带来了全新的可能性。

子曰

2023年7月26日,网易有道正式发布国内首个教育领域垂直大模型——“子曰”。其研发旨在运用人工智能技术,解决教育场景实际问题,为学习者提供更高效、个性化的学习体验。自发布以来,“子曰”不断升级迭代,在教育大模型垂直应用领域取得众多突破。2023年11月,顺利通过双新评估,成为首批通

CivitAI - AI模型训练社区

CivitAI是一个专注于人工智能模型训练的平台,旨在为开发者、数据科学家和企业提供一个高效、可扩展的环境,以训练和部署机器学习模型

无问芯穹

无问芯穹(Infinigence),一个专为大型模型应用开发者量身打造的企业级AI服务平台,正引领着我们步入AIGC(人工智能生成内容)的新纪元。它致力于在AI 2.0时代提供创新解决方案,搭建起大模型与多样化芯片之间的高效部署桥梁,为通用人工智能(AGI)时代的基础设施建设贡献力量。

Quasar Alpha

Quasar Alpha是一款近期神秘亮相的全新AI模型,由一家未具名的模型实验室推出,被称为其首款“隐秘”模型,是即将发布的长上下文基础模型的预发布版本。它凭借超长的上下文处理能力、优化的编码能力,以及免费开放策略,迅速成为业界热议焦点,为AI技术发展增添了新期待。

0

0