Gemma 3

2897

1

1

1

Gemma-3是谷歌最新开源的多模态大模型,主打低成本高性能。该模型共有1B(10亿)、4B(40亿)、12B(120亿)和27B(270亿)四种参数规模,即便最大的27B参数模型,也只需要一张Nvidia H100显卡就能高效推理。相比同类模型,Gemma-3在达到相同效果时,算力需求降低了10倍

工具标签:

直达网站

工具介绍

一、Gemma-3介绍

Gemma-3是谷歌最新开源的多模态大模型,主打低成本高性能。该模型共有1B(10亿)、4B(40亿)、12B(120亿)和27B(270亿)四种参数规模,即便最大的27B参数模型,也只需要一张Nvidia H100显卡就能高效推理。相比同类模型,Gemma-3在达到相同效果时,算力需求降低了10倍,是目前最强的小参数模型之一。

二、架构与技术亮点

- 通用解码器Transformer架构:Gemma-3采用了与前两代相同的通用解码器Transformer架构,但进行了众多创新和优化。

- 局部和全局自注意力层交错架构:为了应对长上下文带来的内存爆炸难题,Gemma-3采用了局部和全局自注意力层交错的架构。每5个局部层之间插入1个全局层,局部层的跨度仅为1024个token。这种设计降低了内存占用,提升了模型处理长上下文的能力。

- 扩展上下文长度:Gemma-3将上下文长度扩展到了128K token(10亿参数模型为32K),提高了模型处理复杂任务的能力。

- 提高全局自注意力层的RoPE基础频率:从10k提升到1M,而局部层频率保持在10k,使模型在长上下文场景下能够更好地捕捉信息,提升性能。

- 多模态能力:Gemma-3能够同时处理文本和图像,集成了定制版的SigLIP视觉编码器。这是一个基于VisionTransformer的编码器,通过CLIP损失的变体进行训练,提升了模型的多模态处理能力。

- 图像嵌入压缩技术:为了降低图像处理的推理成本,Gemma-3采用了创新的图像嵌入压缩技术。将视觉嵌入压缩为固定大小的256个向量,从而在不损失关键信息的前提下,显著减少了计算资源的消耗。

- Pan&Scan方法:允许模型灵活处理不同分辨率和宽高比的图像。通过将图像分割成多个固定大小的区域,并将这些区域调整到统一的分辨率后输入编码器,避免了因图像尺寸不一致而导致的信息丢失或变形问题。

三、高效训练过程

- 增加token预算:为适应图像和文本混合数据的训练需求,Gemma-3使用了比Gemma 2更大的token预算。27B参数的模型训练使用14T token,12B参数模型使用12T,4B参数模型使用4T,1B参数模型使用2T。

- 提升语言覆盖范围:增加了多语言数据,包括单语和并行数据,并借鉴特定策略处理语言表示不平衡的问题,以此提升模型的语言覆盖范围和多语言处理能力。Gemma-3支持140种语言,其中35种语言开箱即用。

- 使用SentencePiece分词器:Gemma-3使用与Gemini 2.0相同的SentencePiece分词器,具备分割数字、保留空格和字节级编码的特性。生成的词汇表包含262k个条目,使模型在处理非英语语言时更加平衡。

- 知识蒸馏技术:在训练优化上,Gemma-3运用知识蒸馏技术。每个token采样256个logits,按照教师概率进行加权,学生模型通过交叉熵损失来学习教师模型在这些样本中的分布。从而提升学生模型的性能。

- 后训练阶段:聚焦于提升模型的特定能力并整合新特性。采用了改进版的知识蒸馏技术,从大型指令微调教师模型中获取知识,同时结合基于改进版BOND、WARM和WARP的强化学习微调阶段。通过多种奖励函数来优化模型,旨在提升模型的帮助性、数学能力、编码能力、推理能力、指令遵循能力和多语言能力,同时最小化模型产生有害输出的可能性。

四、性能测试

谷歌在MGSM、Global-MMLU-Lite、WMT24++、RULER、MRCR等众多主流平台对Gemma-3进行了评估。结果显示,Gemma-3在多模态任务中表现出色,例如在DocVQA、InfoVQA和TextVQA等任务中,其性能显著优于前代模型。

在长文本处理方面,Gemma-3的27B模型在RULER128K上达到了66.0%的准确率,展现了强大的长文本处理能力。

在多语言支持上,Gemma-3在MGSM和Global-MMLU-Lite等任务中也取得了优异成绩。在对话能力评估中,Gemma-3的27B指令调优版本在Chatbot Arena中的Elo分数为1338,排名进入前10,接近DeepSeek-R1等大型模型。

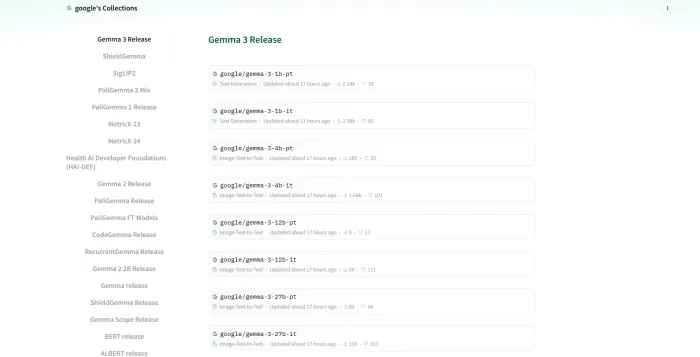

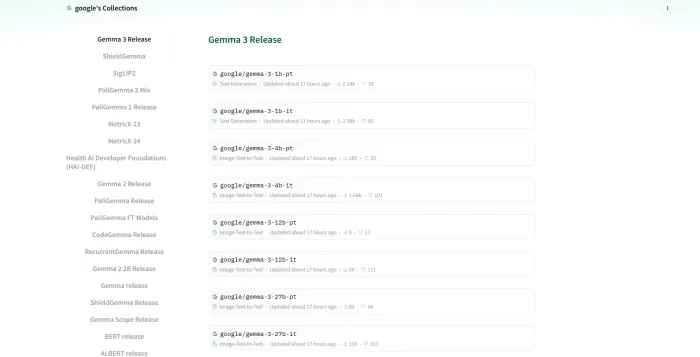

五、开源与应用

Gemma-3已经开源,开发者可以通过指定的开源地址获取模型和相关资源。该模型专为开发者设计,旨在支持他们构建能够在多种设备上运行的人工智能应用,无论是手机还是工作站,均可实现无缝运行。Gemma-3的推出,标志着谷歌在AI技术领域又迈出了重要一步,将进一步推动低成本、高性能AI模型的发展和应用。

概括起来,Gemma-3是一款具有强大性能和广泛应用前景的多模态大模型,值得开发者和AI爱好者关注和探索。

评论

全部评论

暂无评论

热门推荐

相关推荐

MMaDA

MMaDA是由普林斯顿大学、字节跳动、清华大学及北京大学联合研发的多模态扩散大语言模型,旨在突破传统多模态模型在架构统一性与后训练方法上的局限性。其核心目标是通过统一的扩散架构,实现文本推理、多模态理解与图像生成的跨领域卓越性能。

Gemini 2.0 Flash Thinking

Gemini 2.0 Flash Thinking是谷歌推出的一款具有推理能力的智能助手模型,它基于先进的人工智能技术开发,旨在加速和简化复杂的思考过程。该模型不仅继承了Gemini 2.0系列的强大功能,还通过特别训练,能够在回答问题时展示其“思考过程”,为用户提供更深入、更透明的分析体验。

Mistral AI

Mistral AI成立于2023年4月,总部位于法国巴黎,作为欧洲AI领域的领军企业,Mistral致力于通过开源模型与商业化服务,打破美国科技巨头的垄断,为全球开发者提供高性能、可信赖的AI解决方案。

Amazon Bedrock

Amazon Bedrock是亚马逊云科技推出的全球最大AI模型平台,属于完全托管服务。它就像一个“AI模型超市”,通过单个API,把AI21 Labs、Anthropic、Cohere、Meta、Mistral AI、Stability AI和亚马逊自家等领先人工智能公司的高性能基础模型汇聚在一起

Babel

Babel是阿里巴巴达摩院推出一款专为多语言处理而设计的开源大型语言模型。不仅支持全球使用人数最多的前 25 种语言,覆盖超 90% 的世界人口,它还将触角伸向了斯瓦希里语、爪哇语、缅甸语这类在开源大语言模型(LLM)领域鲜有人问津的语种。这一极具前瞻性的行动,势必将为数十亿以这些语言服务

智谱清言

智谱清言是由北京智谱华章科技有限公司推出的一款生成式AI助手,也可被称为ChatGLM。它集文本生成、图片生成、音视频生成等多种功能于一体的智能创作系统,基于深度学习技术,可以实现文章自动生成、智能改写、关键词提取等功能。

Fabric 1.0

VEED Fabric 1.0是VEED.IO 推出的全球首款AI会说话视频模型,它实现了从静态图像到动态叙事的重大跨越,仅需一张图片结合语音输入,就能生成最长1分钟、具备逼真唇形同步和自然面部表情的会话视频。该模型专为“talking head”视频设计,生成速度极快,成本大幅降低,还集成多种生态

Gitee AI(模力方舟)

Gitee AI(模力方舟)是开源中国针对中国市场和用户需求,推出的一站式AI大模型托管平台。它致力于构建一个活跃的开发者社区,为开发者提供从模型托管、训练、部署到应用落地的全方位服务。通过汇聚最新的AI模型、数据集和应用场景,旨在帮助开发者和企业更高效地实现AI技术的落地和应用。

1

1