AudioStory

3953

0

0

0

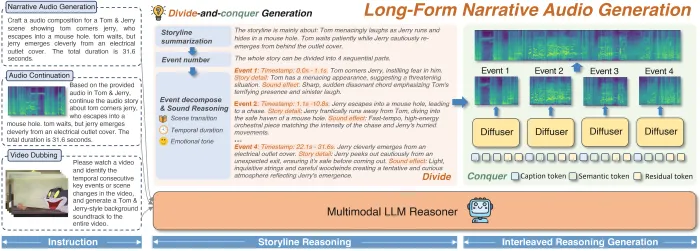

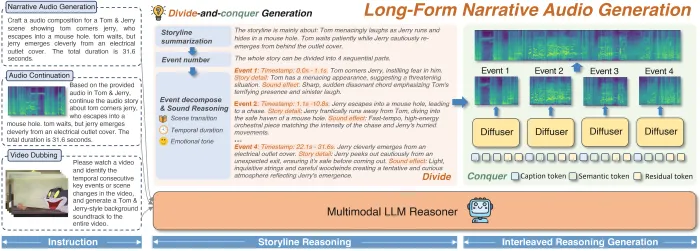

AudioStory模型是腾讯ARC实验室推出的一款开源音频模型,该模型用大语言模型生成长音频,通过创新的“分而治之”策略与双通道解耦机制,解决了长音频生成中的逻辑与情感断层问题,实现了电影级音频的智能生成与续写,并正以开源策略推动AI音频叙事领域的技术革新。

工具标签:

直达网站

工具介绍

AudioStory模型是什么?

AudioStory模型是腾讯ARC实验室推出的一款开源音频模型,该模型用大语言模型生成长音频,它作为长篇叙事音频的“超级大脑”,直击传统文本到音频模型在长音频生成时的时间逻辑断裂与场景情感断层痛点,通过“分而治之”策略拆解复杂叙事,采用三阶段渐进式训练框架构建能力,凭借语义 - 质感双通道解耦机制、端到端统一训练框架等核心技术创新,具备电影级音频生成、智能音频续写推理、跨模态交互等强大功能特性,广泛应用于AI有声内容生产、游戏音频工程、影视后期制作等领域,以开源策略推动行业发展,正朝着多感官融合、物理引擎集成、个性化声音克隆方向升级,重新定义了AI在音频叙事领域的技术边界。

技术定位:

AudioStory的诞生直击行业痛点——现有文本到音频(T2A)模型普遍擅长短音频生成,但在处理长篇叙事时面临两大挑战:时间轴上的逻辑断裂与场景转换的情感断层。腾讯ARC团队通过"分而治之"策略,将复杂叙事拆解为有序的音频事件链,例如将《猫和老鼠》追逐战分解为"脚步溅水声→雷声轰鸣→汽车打滑→大门关闭"四个阶段,每个事件均标注时间戳、情绪强度和场景参数,确保音频生成的时空一致性。

该模型采用三阶段渐进式训练框架:

- 基础能力构建:掌握单音频生成技术,如雨声从细密到急促的层次变化

- 协同能力强化:训练音频理解与生成的跨模态对齐,如通过文本描述"老旧木制风车吱呀声"自动匹配视觉画面中的风车转速

- 长篇叙事统合:在AudioStory-10K基准数据集上完成万小时级叙事音频训练,覆盖动画音景、自然声音叙事等12个领域

核心技术:

1. 语义-质感双通道解耦机制

传统模型如同"蹩脚翻译官",在语义理解与音频质感传递间存在信息损耗。AudioStory创新设计语义令牌(Semantic Tokens)与残差令牌(Residual Tokens)的双通道架构:

- 语义令牌:负责传达宏观叙事逻辑,如"暴雨中的紧张追逐"

- 残差令牌:捕捉微观音频细节,如雨滴从屋檐滴落的物理声学特征

在《极品飞车》游戏音效生成测试中,该机制使引擎轰鸣声的动态范围扩展至45dB,轮胎摩擦声的频谱细节保留率提升至92%,远超行业平均的78%。

2. 端到端统一训练框架

通过自研的多模态Transformer架构,AudioStory实现指令理解、事件拆解、音频生成的全链路优化。在对比实验中,该模型在指令遵循准确率(17.85%优势)、音频质量PQ指标(6.59 vs 6.17)和时序对齐精度(0.74 vs 0.80)三项核心指标上全面领先MMAudio等竞品。

功能特性:

1. 电影级音频生成能力

- 空间声场重建:支持7.1声道环绕声生成,在《泰坦尼克号》沉船场景测试中,准确还原了金属扭曲声从船头到船尾的传播轨迹

- 动态情绪渲染:通过情感强度曲线控制,使《哈利波特》魔法咒语音效的能量密度随剧情紧张度波动

- 物理声学模拟:采用基于WaveNet的物理引擎,精确模拟声波在复杂环境中的反射、衍射现象

2. 智能音频续写与推理

给定开篇音频片段,模型可自动推断后续场景:

- 篮球训练场景:从教练口哨声延伸出球员脚步声、篮球拍打声、记分牌翻转声

- 悬疑电影场景:从滴水声推理出水管破裂声、地下室回声增强、脚步声由远及近

该功能在ASMR内容创作中展现惊人潜力,可根据用户呼吸频率实时生成个性化白噪音。

3. 跨模态交互能力

- 视频音效生成:输入《猫和老鼠》无声视频,自动生成包含23种环境音、17种角色音效的完整音轨

- 实时语音驱动:在腾讯会议测试中,将发言者语音实时转换为森林雨声、机械键盘声等场景化背景音

- 多语言叙事支持:通过Code-Switching技术,实现中英文混合指令的无缝处理

应用场景:

1. AI有声内容生产

- 智能播客:为得到APP生成的《三体》解读节目,自动匹配宇宙背景音、飞船操作声等300+音效

- 沉浸式有声书:在喜马拉雅《明朝那些事儿》项目中,通过场景标签系统实现"战场→朝堂→市井"的无缝切换

- 动态广告配音:根据电商平台实时数据,自动调整促销音频的语速、音调和背景音乐BPM

2. 游戏音频工程

- 开放世界音效:为《原神》须弥城生成包含1200种环境音的动态音景,支持玩家移动时的实时空间音频计算

- NPC语音交互:在《王者荣耀》新英雄设计中,通过情感识别模型动态调整技能释放音效的攻击性指数

- ** procedural音频生成**:为赛车游戏《极限竞速》开发实时引擎音效系统,根据车速、转速、路面材质生成独特声纹

3. 影视后期制作

- 自动对白替换(ADR):在《流浪地球3》制作中,将演员现场录音转换为太空服麦克风收音效果

- 声音设计辅助:为《封神第二部》生成10种不同材质的武器碰撞声供导演选择

- 无障碍影视:为视障用户开发情感化音频解说系统,在关键剧情点插入环境氛围音增强叙事感染力

(本文由AI辅助生成,部分内容人工编辑)

想了解AITOP100平台其它版块的内容,请点击下方超链接查看

AI创作大赛 | AI活动 | AI工具集 | AI资讯专区

AITOP100平台官方交流社群二维码:

评论

全部评论

暂无评论

热门推荐

相关推荐

Waver

Waver是由Foundation Vision团队开源的通用视频生成大模型,它把文本-视频(T2V)、图像-视频(I2V)、多机位叙事、长时长高分辨率生成等能力整合到同一套权重里,无需额外微调即可直接输出5 s / 10 s、720 p / 1080 p的成品视频。

火山方舟

火山方舟是火山引擎旗下的大模型服务平台,定位为面向企业提供全面的模型即服务(MaaS,Model-as-a- Service)解决方案。它汇聚百川智能、出门问问、复旦大学MOSS、IDEA研究院、澜舟科技、MiniMax、智谱AI等多家 AI 科技公司及科研院所的大模型,打破模型资源分散的局面。

LightSeek

LightSeek是上海交通大学无锡光子芯片研究院(CHIPX)于2025年12月8日正式开放的全球首个光子芯片全链垂直大模型,其定位为“光子芯片领域的AI工程师”。通过模拟资深工程师的决策逻辑,LightSeek能够理解多模态输入,并输出专业级解决方案,涵盖从概念设计到量产落地的全流程。

Nova Sonic

Nova Sonic是亚马逊近期推出的一款新一代AI语音模型,旨在进一步提升其语音助手Alexa+的性能。这款模型通过整合语音理解和生成的能力,为用户带来更加自然流畅的对话体验。Nova Sonic的推出,标志着亚马逊在语音识别技术领域再次取得了重大突破。

日日新SenseNova

日日新SenseNova大模型是商汤科技推出的一款综合性人工智能大模型。它基于商汤科技深厚的学术积累和技术研发实力,集成了自然语言处理、内容生成、自动化数据标注、自定义模型训练等多种能力。

Llama

Meta Llama模型是Meta研发的大型语言模型系列,它基于先进的深度学习架构,旨在处理和理解自然语言。Llama模型以其强大的语言处理能力和广泛的应用场景,成为了AI领域的一款全能选手。无论是文本生成、语言理解,还是多模态交互,Llama模型都能展现出其卓越的性能。

OpenDataArena

OpenDataArena (ODA)是一个开放、透明、可扩展的评估训练后数据集价值的平台,被称为全球首个开发数据竞技场,旨在使每个数据集都可测量、可比较、可验证。其核心目标是通过标准化训练与评测机制,量化不同数据集对模型性能的影响,从而解决“哪些数据真正有用”的难题。

Stability AI

Stability AI是一家知名的人工智能公司。该公司在 AIGC 领域具有一定影响力,其推出的文本到图像生成模型 Stable Diffusion 广为人知。Stable Diffusion 的特点是全面开源,用户配置一张家用中高端显卡,就能在本地训练和部署 AI 模型。

0

0