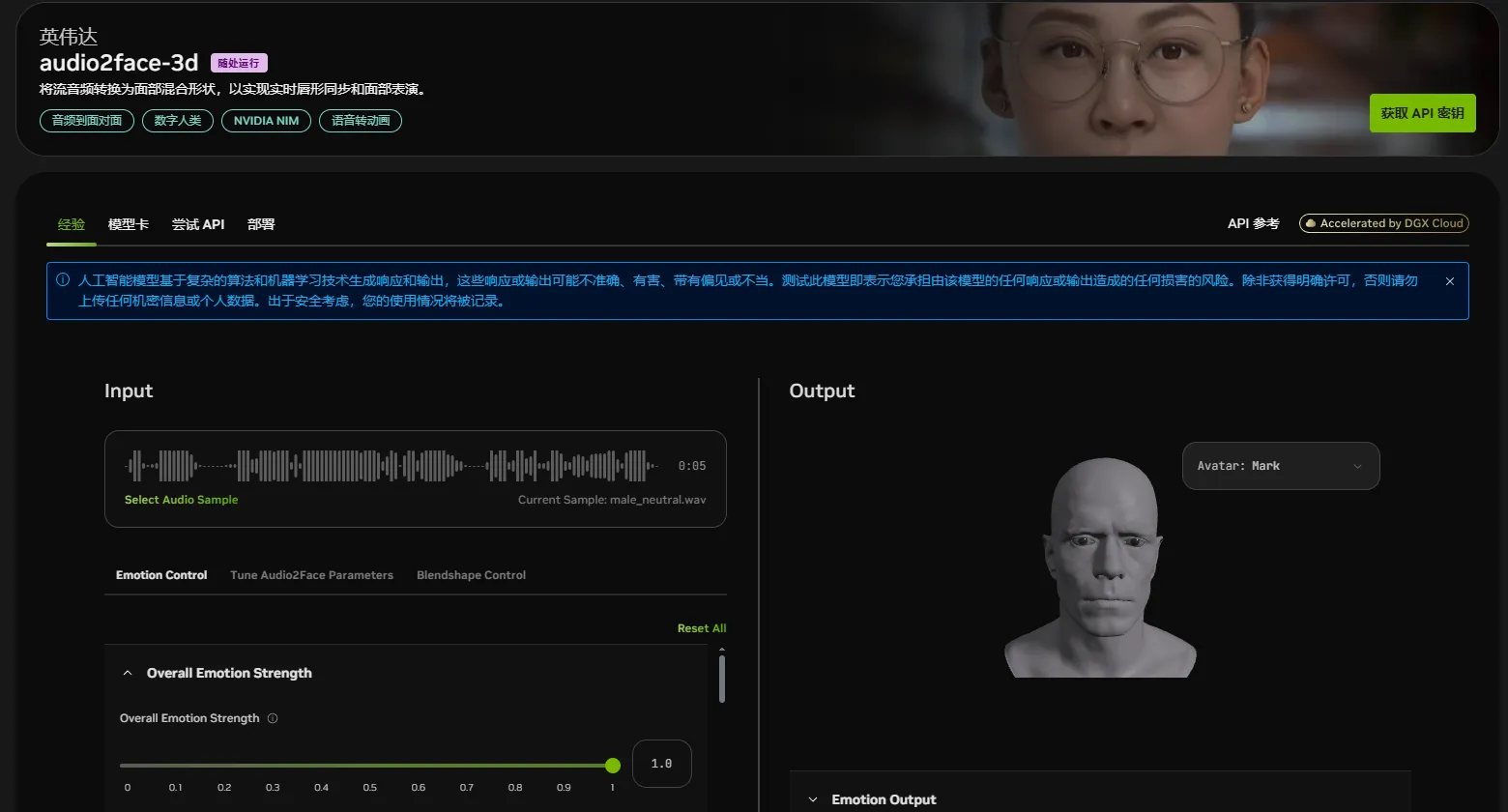

2025年9月25日,游戏和影视行业迎来一则重磅消息:英伟达在著名社交媒体平台“X”的官方账号上发推文宣布:英伟达正式开源其生成式AI面部动画模型Audio2Face,这不是简单的技术升级,而是直接把“黑科技”摆在了开发者面前,谁能不心动?要知道,以往这类技术要么闭源高价,要么功能单一,而Audio2Face不仅开源核心算法,还打包送上SDK和完整训练框架,这波操作简直“卷”出新高度。

Audio2Face的原理其实不难理解——它就像个“声音翻译官”,通过分析音频中的音素、语调等声学特征,实时驱动虚拟角色的面部动作,生成精准的口型同步和自然的情感表情。对比传统面部动画制作,以往需要逐帧调整的繁琐流程,现在靠AI就能搞定,效率直接翻倍!这项技术不仅在游戏领域大显身手,影视制作、客户服务等行业也能用上,比如客服虚拟人就能根据对话情绪实时变脸,是不是比“面瘫”机器人有趣多了?

有趣的是,英伟达这次开源的不仅是技术,还附赠了“使用说明书”——从Autodesk Maya的本地插件到Unreal Engine5.5的适配工具,开发者拿到就能直接“开箱即用”。这种“保姆级”支持,让不少中小团队也能轻松玩转AI面部动画,毕竟以前想用类似技术,光是买授权就能让预算“瘦身”一半。

Audio2Face支持两种运行模式:

- 离线渲染适合预录制音频,比如影视动画的后期制作;

- 实时流式处理则能动态驱动AI角色,比如游戏中的NPC对话。

更贴心的是,英伟达还开源了回归模型和扩散模型,开发者可以用自己的数据微调模型,比如让虚拟角色的表情更符合东方审美,或者让口型同步更贴合方言发音。这种“定制化”能力,让技术从“能用”升级到“好用”。

目前,这项技术已被多家游戏厂商“抢着用”。比如Survios在《异形:侠盗入侵进化版》中集成Audio2Face后,口型同步和面部捕捉的流程从“手动调帧”变成“AI一键生成”,效率提升超60%;

Farm51工作室在《切尔诺贝利人2:禁区》中应用后,角色表情细腻度直接“拉满”,创新总监Wojciech Pazdur甚至直言:“这是革命性突破!”毕竟,以前做面部动画要靠动作捕捉演员“表演”,现在靠音频就能生成,成本和时间都省了一大截。

从行业角度看,英伟达的这次开源不仅是技术共享,更是推动虚拟角色表现进化的关键一步。随着AI技术的普及,未来的游戏和影视角色将更真实、更生动,甚至能根据观众情绪实时调整表情——这种“沉浸式体验”,或许就是下一代娱乐的核心竞争力。

入口链接:https://build.nvidia.com/nvidia/audio2face-3d

想了解AITOP100平台其它版块的内容,请点击下方超链接查看

AI创作大赛 | AI活动 | AI工具集 | AI资讯专区

AITOP100平台官方交流社群二维码: