2025年10月27日,中国初创公司MiniMax在著名社交媒体平台“X”的官方账号上发推文宣布正式上线全球首个专为编码与代理工作流设计的大语言模型MiniMax M2。这款模型究竟有多猛?每令牌成本仅是Anthropic Claude Sonnet的8%,速度却飙升2倍!这不就是开发者梦寐以求的"既要马儿跑,又要马儿少吃草"吗?

官网地址:MiniMax网页版官网

模型地址:https://huggingface.co/MiniMaxAI/MiniMax-M2

项目地址:https://platform.minimax.io/docs/guides/text-generation

MoE架构:用100亿参数撬动2300亿性能

传统大模型总被诟病"参数堆得越多,钱包瘪得越快",但M2偏要打破这个魔咒。它总参数量达2300亿,推理时却只激活100亿参数,靠什么?秘密就藏在升级至的混合专家(MoE)架构里。这个架构就像智能交通系统,只让需要的"专家"上路,计算开销直接砍半。

更夸张的是它的处理能力:支持204,800令牌的上下文窗口,输出能力高达131,072令牌。这意味着什么?打个比方,它能像老司机一样稳稳处理超复杂的长程任务,代码生成、多文件编辑、编译-运行-修复全流程一气呵成。

核心亮点:代码生成与工具链操控双王炸

代码生成:开发者的"外挂神器"

M2专为开发者工作流而生,代码生成、多文件协同编辑、编译-运行-修复循环、测试验证这些活儿,它干得比老程序员还利索。更绝的是,它能和Claude Code、Cursor等主流工具无缝集成,端到端开发需求?安排!

代理性能:工具链的"全能指挥官"

在代理工作流领域,M2简直是个"六边形战士"。多云平台(MCP)操作、Shell命令执行、浏览器交互、代码执行...这些长期工具链任务,它处理得稳如泰山。在BrowseComp评估中,复杂信息定位、证据追溯、故障恢复这些高难度动作,M2的表现让竞品集体沉默。

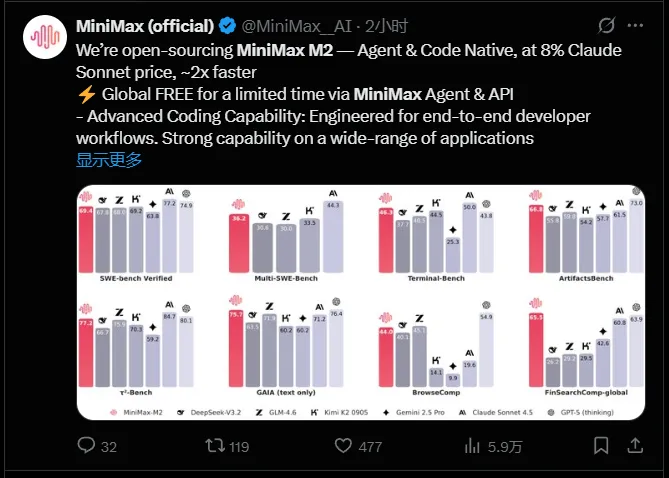

基准测试:开源模型首次碾压闭源大厂

独立机构Artificial Analysis的测试结果让行业震惊:M2在数学、科学、指令遵循、编码和代理工具使用等综合指标上,直接登顶全球开源模型榜首!更夸张的是,在数学、编码和代理任务中,它居然把闭源模型Claude3Opus都甩在身后。

| 对比维度 | MiniMax M2 | Claude Sonnet | Claude3Opus |

|---|---|---|---|

| 每令牌成本 | 竞品8% | 100% | 未公开 |

| 推理速度 | 提升2倍 | 基准 | 基准 |

| 数学能力 | 超越 | 基准 | 被超越 |

| 编码能力 | 超越 | 基准 | 被超越 |

开放生态:免费+开源,开发者狂喜

MiniMax这次玩得够大:采用Apache2.0许可证开源,全球开发者可随意商业使用和微调。目前通过MiniMax代理平台和API提供限时免费访问,模型权重已上架Hugging Face,本地部署?随便你!

社区反馈显示,M2在敏感查询中的事实可靠性甚至优于部分闭源模型。这对于金融、医疗等安全性要求高的场景,简直就是"及时雨"。

你知道吗? 传统大模型训练一次的成本够买辆特斯拉,而M2的出现让中小企业也能玩转AI开发。

性能实测:低延迟+高并发,实时应用稳了

在实时应用场景中,M2的表现堪称完美。低延迟、高并发这些关键词,它全占。无论是智能客服、自动化运维还是实时数据分析,M2都能轻松驾驭。有开发者实测:"以前用闭源模型,响应慢得想摔键盘,现在M2的响应速度比我还快!"

从架构创新到性能突破,从开源生态到商业落地,MiniMax M2正在重新定义AI开发的标准。这款模型的出现,不仅让开发者有了更趁手的工具,更让整个AI行业看到了技术普惠的可能。2025年的AI圈,因为M2的到来,注定不会平凡。

想了解AITOP100平台其它版块的内容,请点击下方超链接查看

AI创作大赛 | AI活动 | AI工具集 | AI资讯专区

AITOP100平台官方交流社群二维码: