VLM-R1:视觉语言理解的新篇章

近日,VLM-R1项目的推出为人工智能领域带来了新的希望。DeepSeek 团队成功地将R1方法应用于视觉语言模型,标志着AI对图像和视频内容的理解将进入一个崭新的阶段。

VLM-R1项目的灵感来源于 DeepSeek 团队去年开源的 R1方法。该方法基于 GRPO (Generative Reward Processing Optimization) 强化学习技术,在自然语言处理任务中取得了卓越的成果。如今,VLM-R1团队将该方法成功应用于视觉语言模型,为多模态人工智能的研究开辟了新的路径。

卓越的性能与泛化能力

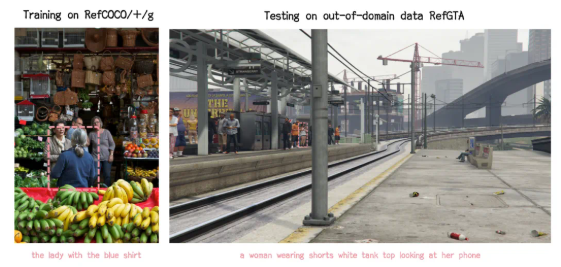

VLM-R1项目的实验结果令人印象深刻。首先,R1方法在复杂场景下展现出极高的稳定性,这对于实际应用至关重要。其次,该模型在泛化能力方面表现出色。在对比实验中,传统的 SFT (Supervised Fine-Tuning) 模型在训练数据以外的测试集上,随着训练步数的增加,性能反而下降。而 VLM-R1 模型则能在训练过程中持续提升性能。这表明,R1方法使模型真正理解了视觉内容,而非仅仅依赖于记忆。

VLM-R1项目上手难度极低,团队提供了完整的训练和评估流程,方便开发者快速使用。在一个实际案例中,模型被要求识别一张美食图片中蛋白质含量最高的食物,结果不仅准确识别,还在图片中精确定位了蛋白质含量最高的鸡蛋饼,体现了其优秀的视觉理解和推理能力。

开源共享与未来展望

VLM-R1的成功不仅验证了 R1方法的通用性,也为多模态模型的训练提供了新的思路,预示着视觉语言模型训练的新趋势。更重要的是,该项目完全开源,感兴趣的开发者可以在 GitHub 上找到相关资源。

总之,VLM-R1的发布为视觉语言模型的研究注入了新的活力,期待更多开发者参与其中,共同推动多模态人工智能技术的不断进步。

更多AI行业最新资讯新闻信息请关注AI人工智能网站--AITOP100平台--AI资讯专区:https://www.aitop100.cn/infomation/index.html